概览

前一阵测试 GB28181,通过信令把海康的 IPC/NVR 视频流获取出来了,也测试了直接保存为 h.264 文件,可以用 FFmpeg 转换为mp4并进行播放。但是如何将实时的PS流推送到RTMP服务器,分发为不同格式的流媒体,一直没有头绪,直到我看到一篇介绍srs的文章《国产开源流媒体SRS4.0对视频监控GB28181的支持》,知道了srs开源流媒体服务器,解决了我的问题。

写这篇文章的时候,GB28181的特性还没完全合并到srs4.0版本,我顺着pr找到提交这一特性的作者Github,下载的开发分支进行的编译测试(官方开发分支我测试时编译失败),但是如果有搜索用户查看到这篇文章,相信此时4.0稳定版本已经可以正常编译。

目前来看,srs 的规划对于GB28181的支持是部分支持,比如提供简单的SIP Server,供IPC的接入,这种方式方便接入摄像头并与之保持心跳,另一种是方式是不启用SIP Server,监听一个指定端口,用户自己实现信令通信,将流调出来后推送到这个端口,srs就能进行解析分发出来,这种方式很灵活。监控设备厂商很多,各自实现的GB28181有时也不规范,如果信令通信也集成到srs中,维护和兼容的工作量很大,能接收PS流并分发出来,功能边界就刚刚好。

真心感谢大佬们为开源的付出,使得流媒体小白能够学习并使用,感谢!

先决条件

1,知晓如何从 IPC/NVR 通过 GB28181 获取PS流。

编译测试步骤

1)拉GIT代码,切换到开发分支

git clone https://gitee.com/winlinvip/srs.oschina.git srs

cd srs/trunk

# 正常是设置主分支版本

#git remote set-url origin https://github.com/ossrs/srs.git

# 我测试的时间节点,主库的开发分支编译失败,使用xialixin版本可以编译通过

git remote set-url origin https://github.com/xialixin/srs.git

git pull

2)切换到开发分支

# git checkout develop

git checkout dev-28181

./configure --with-gb28181

sudo make clean && sudo make

3)编辑配置文件

我这里是配置为自行推送PS流到srs,并且根据官方文档,添加了 hls 和 http_remux(http-flv) 的分发配置项。

# push gb28181 stream to SRS.

listen 1935;

max_connections 1000;

daemon off;

srs_log_tank console;

http_api {

enabled on;

listen 1985;

}

http_server {

enabled on;

listen 8080;

dir ./objs/nginx/html;

}

stats {

network 0;

}

stream_caster {

enabled on;

caster gb28181;

# 转发流到rtmp服务器地址与端口

# TODO: https://github.com/ossrs/srs/pull/1679/files#r400875104

# [stream] is VideoChannelCodecID(视频通道编码ID) for sip

# 自动创建的道通[stream] 是‘chid[ssrc]’ [ssrc]是rtp的ssrc

# [ssrc] rtp中的ssrc

output rtmp://127.0.0.1:1935/live/[stream];

# 接收设备端rtp流的多路复用端口

listen 9000;

# rtp接收监听端口范围,最小值

rtp_port_min 58200;

# rtp接收监听端口范围,最大值

rtp_port_max 58300;

# 是否等待关键帧之后,再转发,

# off:不需等待,直接转发

# on:等第一个关键帧后,再转发

wait_keyframe off;

# rtp包空闲等待时间,如果指定时间没有收到任何包

# rtp监听连接自动停止,发送BYE命令

rtp_idle_timeout 30;

# 是否转发音频流

# 目前只支持aac格式,所以需要设备支持aac格式

# on:转发音频

# off:不转发音频,只有视频

# *注意*!!!:flv 只支持11025 22050 44100 三种

# 如果设备端没有三种中任何一个,转发时为自动选择一种格式

# 同时也会将adts的头封装在flv aac raw数据中

# 这样的话播放器为自动通过adts头自动选择采样频率

# 像ffplay, vlc都可以,但是flash是没有声音,

# 因为flash,只支持11025 22050 44100

audio_enable off;

# 服务器主机号,可以域名或ip地址

# 也就是设备端将媒体发送的地址,如果是服务器是内外网

# 需要写外网地址,

# 调用api创建stream session时返回ip地址也是host

# $CANDIDATE 是系统环境变量,从环境变量获取地址,如果没有配置,用*

# *代表指定stats network 的网卡号地址,如果没有配置network,默认则是第0号网卡地址

# TODO: https://github.com/ossrs/srs/pull/1679/files#r400917594

host $CANDIDATE;

#根据收到ps rtp包自带创建rtmp媒体通道,不需要api接口创建

#rtmp地址参数[stream] 就是通道id 格式chid[ssrc]

auto_create_channel on;

sip {

# 是否启用srs内部sip信令

# 为on信令走srs, off 只转发ps流

enabled off;

# sip监听udp端口

listen 5060;

# SIP server ID(SIP服务器ID).

# 设备端配置编号需要与该值一致,否则无法注册

serial 34020000002000000001;

# SIP server domain(SIP服务器域)

realm 3402000000;

# 服务端发送ack后,接收回应的超时时间,单位为秒

# 如果指定时间没有回应,认为失败

ack_timeout 30;

# 设备心跳维持时间,如果指定时间内(秒)没有接收一个心跳

# 认为设备离线

keepalive_timeout 120;

# 注册之后是否自动给设备端发送invite

# on: 是 off 不是,需要通过api控制

auto_play on;

# 设备将流发送的端口,是否固定

# on 发送流到多路复用端口 如9000

# off 自动从rtp_mix_port - rtp_max_port 之间的值中

# 选一个可以用的端口

invite_port_fixed on;

}

}

vhost __defaultVhost__ {

hls {

enabled on;

hls_path ./objs/nginx/html;

hls_fragment 5;

hls_window 60;

}

http_remux {

enabled on;

mount [vhost]/[app]/[stream].flv;

hstrs on;

}

}

4)启动服务

./objs/srs -c conf/push.gb28181.conf

5)发送信令让NVR推流

INVITE 命令中的 SDP 描述,此时接收流媒体的地址要写部署 srs 服务的地址,9000 就是上边配置文件指定的接收流的监听端口。

v=0

o=1001 0 0 IN IP4 192.168.3.189

s=Play

c=IN IP4 192.168.3.189

t=0 0

m=video 9000 RTP/AVP 96

a=recvonly

a=rtpmap:96 PS/90000

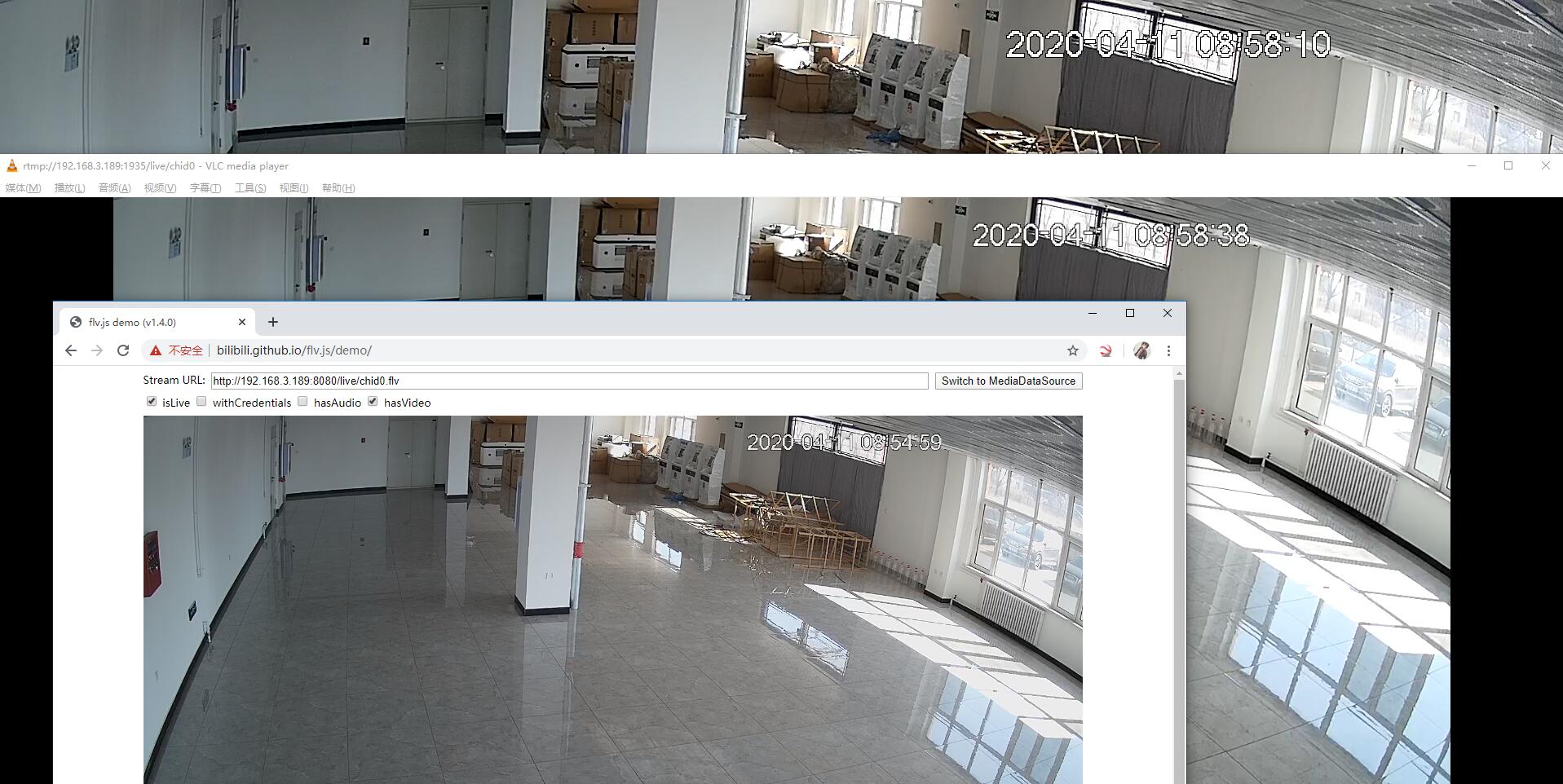

测试播放

RTMP 流地址:rtmp://192.168.3.189:1935/live/chid0

HLS 流地址:http://192.168.3.189:8080/live/chid0.m3u8

HTTP-FLV 流地址:http://192.168.3.189:8080/live/chid0.flv

PS流经过分发,RTMP,HLS,HTTP-FLV 就都能通过浏览器进行播放了~

srs 还支持分发为其它流,如 Dash 等,文档在这里:v4_CN_Home

HLS 延时是最高的,RTMP 流与 HTTP-FLV 实时性都很好。

查看状态信息

使用:http://ossrs.net/console/ 填写服务器IP地址,端口 1985

本文是一篇很简单的笔记,用来记录GB28181的流可以直接推送给SRS,这也是最近SRS支持的功能,希望能帮助跟我一样不知道PS流不知道怎么分发出去的朋友。

参考